1. 进行编程练习或实现神经网络的logistic回归时,每次创建数组时将其定义为列向量或行向量,如a=np.randm.randn(5,1)或a=np.randm.randn(1,5)。如果不确定一个向量的具体维度,可以用assert( ) 进行声明。

2. [1]、[2]样式的上标表示神经网络的不同层,(1)、(2)等则表示第 i 个训练样本。

3. 经验法则:如果输出值是0或1的二元分类,那么sigmoid函数很适合作为输出层的激活函数,然后其他单元都用ReLU函数。

4.

A = np.random.randn(4,3)

B = np.sum(A, axis = 1, keepdims = True)

其中,np.sum用来对矩阵的一个维度求和,axis=1表示水平相加求和,keepdims=True 起到开关的作用,防止输出秩为1的数组。

5. 如果已经建立一个神经网络,且将权重和偏差初始化为0,则第一个隐藏层中的每个神经元节点将执行相同的计算。即使经过多次的梯度下降迭代后,层中的每个神经元节点都会计算出与其他神经元节点相同的东西。

6. Logistic回归没有隐藏层。 如果将权重初始化为零,则Logistic回归中的第一个示例x将输出零,但Logistic回归的导数取决于不是零的输入x(因为没有隐藏层)。 因此,在第二次迭代中,如果x不是常量向量,则权值遵循x的分布并且彼此不同。

7. “cache”我们用它传递前向传播中计算的变量到相应的反向传播步骤,它包含用于计算导数的反向传播的有用值。

8. 参数:、、、等。

超参数:学习率,循环的数量,神经网络的层数L,迭代次数,隐藏单元数,可选的激活函数。

超参数决定参数。

9. 第四周测验的第9题:

在2层隐层神经网络中,说法正确的有:

的维度为 (4, 4), 的维度为 (4, 1),

的维度为 (3, 4),的维度为 (3, 1),

的维度为 (1, 3),的维度为 (1, 1)。

根据两个答案倒推出两个隐藏层,一共是4个输入,隐藏层L1是4个神经元,L2是3个神经元。再用剩下的选项来检验,发现是正确的。掌握原理即可。(通常不将输入层看做一个标准的层)

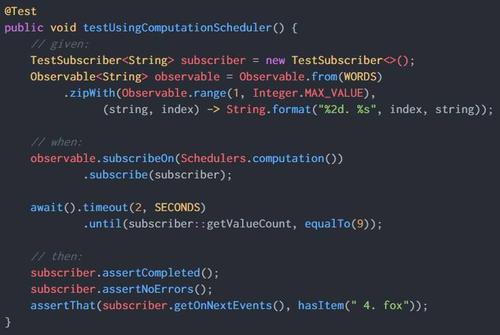

图片如图所示:

本文发布于:2024-01-29 04:15:11,感谢您对本站的认可!

本文链接:https://www.4u4v.net/it/170647291612623.html

版权声明:本站内容均来自互联网,仅供演示用,请勿用于商业和其他非法用途。如果侵犯了您的权益请与我们联系,我们将在24小时内删除。

| 留言与评论(共有 0 条评论) |