UNSUPERVISED PRETRAINING TRANSFERS WELL ACROSS LANGUAGES

UNSUPERVISED PRETRAINING TRANSFERS WELL ACROSS LANGUAGES

1. 论文思路:

作者基于CPC的自监督预训练方法提出了改进版本,解决了原CPC配置中encoder通过batch normalization 泄露信息的问题,并用一层Transformer layer 提升了phoneme 的表征能力。最终得出的主要结论是:通过改进版cpc学习到的表征可以跨语音使用,并能够取得甚至超过有监督预训练的效果。

2. 模型改进

- CPC

将输入T时间长度的音频序列过一个encoder (五层卷积网络) 得到 z t z_t zt, 然后将 z t z_t zt经过一个序列模型得到最终的表征 c t c_t ct (公式中用 z t z_t zt表示.

基于contrast loss利用 c t c_t ct去预估未来K时间步的 z t z_t zt.

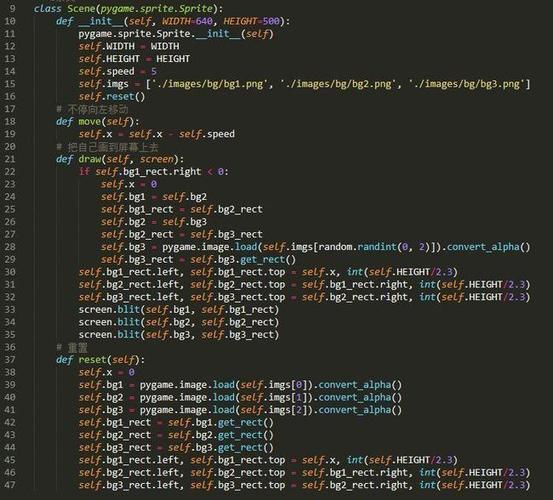

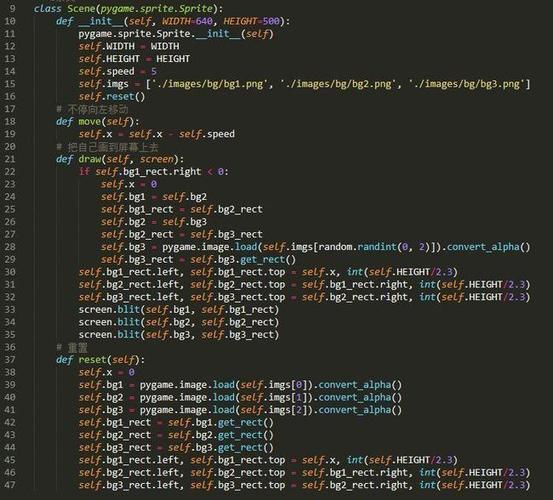

- 改进版CPC

问题:

(1)原CPC的训练不稳定,经常出现收敛问题,主要是因为encoder 中层与层之间采用batch normalization,encoder 在sequence中是共享的,这样在过去和未来的窗口存在参数信息的泄露。改用channel-wise normalization.->layer nomalization.

(2)在做contrast loss 的时候采用了线性的分类器,因此学到的phonemes embedding 编码也倾向于是线性可分的。但是实际上的表征应该是包含时间窗的。因此可以采用其他替代的方法,比如将future representations 再过一个sequence model 比如transformer,不同结构的对比结果为:

3.实验结果

实验配置:将编码后的特征经过线性分类器做音素分类。

评判标准:ABX score 通过估计不同语音片段彼此接近的概率来衡量不同音素之间的可分性。

- Within language

取得了在within language下 within 和 across speaker 实验优于CPC的实验结果,并且与一些专注音素识别的无监督模型结果相当。 - Cross-lingual

在target language 的训练数据只有1h的条件下,改进版CPC这种自监督方法表现良好,超过CPC 5.4个PER,仅比有监督模型低1.3个点。同时基本超过了其他无监督模型的结果。

模型不冻住做finetune的结果更好。

文章总结:

通过改进版CPC编码的向量可在跨语言的数据集上均取得不错的效果,解决了一些小语种训练数据少的问题。